none

none

#Introduction

#Introduction

#SimulationNumérique

#Cybersécurité

#JeuxVidéo

#FabricationAdditive

#SpacialisationSonore

#IntelligenceArtificielle

#RéalitéAugmentée

#Blockchain

#Modélisation 3D

#E-santé

Guillaume Poupard

Silke Biermann

Francis Bach

Frédéric Mazzella

Christel Heydemann

- #Introduction -

La France fait partie des grands leaders

dans le domaine des mathématiques.

Grâce à ses universités et institutions de

renommée mondiale, elle forme des

talents scientifiques de haut niveau en

mathématiques et dans les disciplines

informatiques qui en découlent. L’École

polytechnique s’inscrit dans cette tradition

d’excellence historique, héritée du

siècle des Lumières, et s'illustre dans ces

disciplines dont les applications bouleversent le monde

actuel et celui de demain.

Formidables potentiels d’innovation,

les mathématiques et l’informatique sont omniprésentes

dans notre société et transforment nos usages

grâce aux innovations de rupture qui en sont issues.

Plus encore, les chercheurs de l'École dans ces différentes

disciplines croisent leurs regards et mènent des

recherches de pointe en s’appuyant sur l’interdisciplinarité

afin de parvenir à des découvertes inédites.

Ils repoussent ainsi les limites de la compréhension du

monde et de la conception de nouvelles technologies,

à l’image des plus illustres contributeurs de ses 225 ans

d’histoire.

Depuis sa création, l’École polytechnique compte, parmi

ses anciens élèves et professeurs, de nombreuses et

nombreux scientifiques, capitaines d’industrie et hauts

responsables d’État dont l’héritage rayonne toujours.

Encore aujourd’hui, des innovations portées par les chercheurs

et les étudiants de l’École naissent de travaux à

la croisée des sciences, dans tous les domaines en forte

croissance tels que la simulation numérique, la cybersécurité,

la fabrication additive, la spatialisation sonore, la

réalité augmentée, la blokchain, la modélisation 3D et la

e-santé.

À travers cet ouvrage, l’École met en avant ses représentantes

et représentants actuels pour leur contribution au

monde et à la science. Ils sont étudiants, doctorants, professeurs

et chercheurs et ils forment la prochaine génération

qui portera l’innovation française et mondiale. Nous

vous invitons à découvrir dix projets phare de l’École qui

façonnent le futur de la science, ainsi que l’éclairage de

cinq experts mettant en perspective les disciplines dont

l’X a fait sa priorité.

À travers ces projets innovants, l’École

réaffirme son ambition de comprendre et de changer le

monde d’aujourd’hui et de demain, et d’agir sur des sujets

à fort impact sociétal.

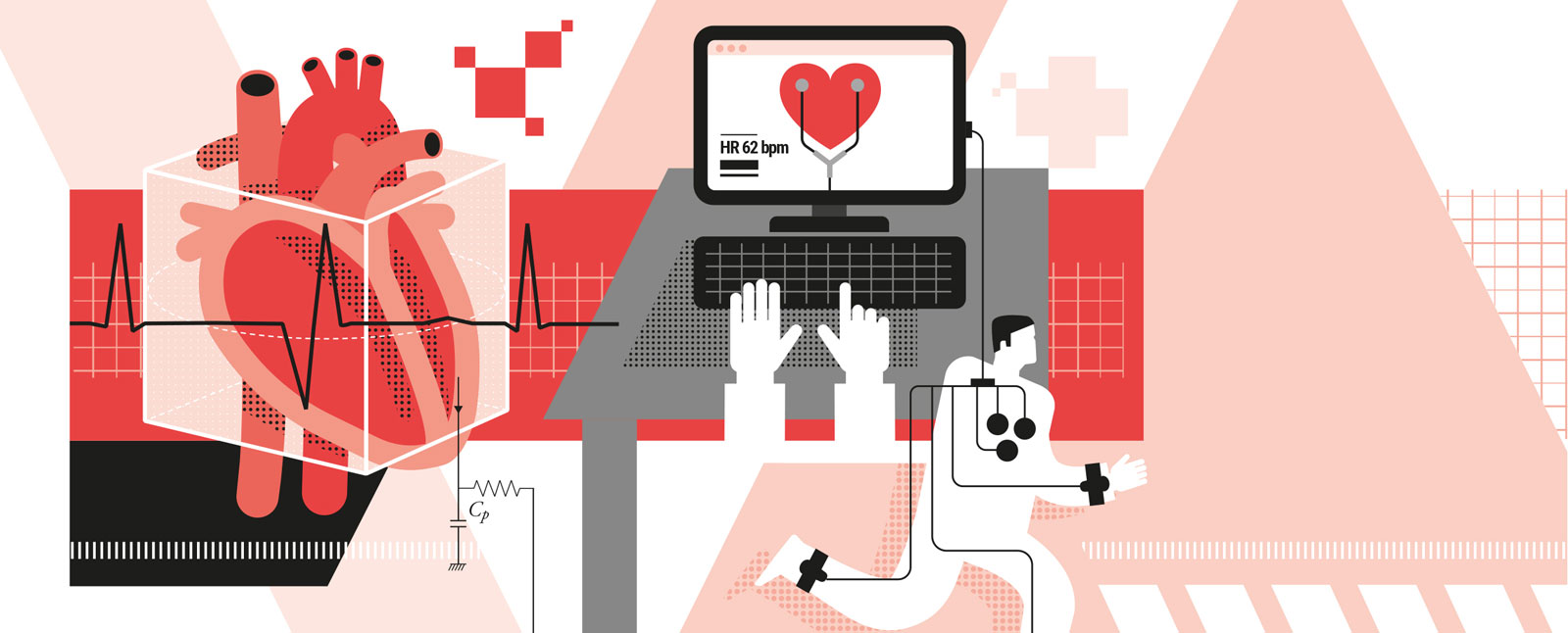

- #SimulationNumérique -

Des chercheurs de l’X et de l’Inria ont réussi à

simuler numériquement et en temps réel un

coeur en train de battre.

Ceci en réduisant et

en simplifiant leur modèle physique de simulation

en 3D du coeur réalisé il y quatre ans. Jusqu’ici, leurs

modèles étaient trop complexes pour obtenir du temps

réel : il fallait environ six heures à un ordinateur pour simuler

un seul battement de coeur.

Cette avancée ouvre des perspectives pour les prédictions

dans le domaine médical. « Ce modèle, une fois

adapté aux données de chaque patient, en intégrant

des signaux tels que l’électrocardiogramme ou des mesures

de pressions déportées, permettrait de diagnostiquer

l’état actuel du coeur d’un individu, mais surtout de

prédire l’état futur de cet organe et d’anticiper ainsi des

anomalies ou maladies éventuelles », explique Philippe

Moireau, responsable de l’équipe commune entre l’X

et l’Inria.

Les chercheurs ont déposé deux brevets en cours d’évaluation

en 2018. Un premier porte sur la détection des

anomalies au cours de la vie quotidienne en s’appuyant

sur les mesures de sismocardiogramme effectuées sur

le thorax.

Il ouvre ainsi la voie à des dispositifs de monitoring

tel qu’un vêtement intelligent ou un autre objet

connecté. Le deuxième brevet est, lui, dédié au monitoring

pendant une anesthésie. Dans le cadre d’un partenariat

entre l’X, l’Inria et l’hôpital Lariboisière (AP-HP),

deux médecins anesthésistes travaillent avec l’équipe

de recherche sur l’application de ce modèle numérique

au monitoring.

Leur objectif : réduire le risque médical,

notamment lié aux événements rares, en exploitant

les modèles et les données récoltées en temps réel lors

des anesthésies.

L’avenir, selon Philippe Moireau, sera de combiner modèle

prédictif et big data pour des prédictions encore

plus précises.

- #Cybersécurité -

Avec le développement des objets connectés,

assurer leur sécurisation devient une priorité.

Face à ce phénomène, la cryptologie assure

l’authentification et la fiabilité des communications

en empêchant une unité malveillante d’interférer

dans l’accès aux données, aux comptes informatiques

ou aux ressources physiques des machines piratées.

Les chercheurs en cryptologie du Laboratoire d’informatique

de l’X travaillent sur ces nouvelles méthodes de

sécurisation des communications.

Lorsque deux parties

communicantes ont besoin de partager une clé de chiffrement,

une méthode utilisée consiste à la cacher dans

la solution d’un problème mathématique complexe. Si

des problèmes d’arithmétique étaient utilisés dans les

années 1970, les clés obtenues, trop volumineuses, ne

conviennent pas aux outils de communications actuels.

Les nouvelles solutions développées par les chercheurs

de l’X s’appuient sur des courbes elliptiques dont les

points, caractérisés par leur algèbre propre, peuvent

être réinjectés dans les problèmes arithmétiques comme

s’ils étaient des nombres.

Ils obtiennent ainsi des problèmes

très concis, extrêmement difficiles à résoudre, qui

conviennent aux outils actuels tels que le mobile.

Toutefois, dans l’objectif de réduire encore l’échelle des

clés de chiffrement pour les adapter aux petits objets

connectés, les chercheurs du laboratoire d’informatique

étudient des problèmes qui seront utilisés demain, en

passant de l’utilisation de courbes à celle de surfaces,

comme celles de Kummer, afin de créer des cryptosystèmes

encore plus efficaces avec des clés cryptographiques

plus compactes et sécurisées.

- #JeuxVidéo -

Il veut faire de son jeu mobile le « Candy Crush » des sciences.

Raphaël Granier de

Cassagnac, chercheur en physique des particules au CNRS, a fait entrer le jeu vidéo

au sein de l’École polytechnique. Directeur de recherche au Laboratoire Leprince-

Ringuet, il développe, avec une petite équipe de designers et d’artistes, un jeu

dédié à la physique des particules.

L’idée de ce jeu est d’immerger le joueur dans un

univers fantasmagorique au sein duquel il explore

le monde des particules élémentaires.

« Au fur et à

mesure qu’il progresse, le joueur découvre une par

une les briques du modèle standard, fabrique des

machines, utilise des télescopes et observe des

gerbes de particules », détaille le chercheur. En plus

de son rôle d’expert scientifique, Raphaël Granier

de Cassagnac co-écrit le scénario de ce jeu.

Car

depuis de nombreuses années, le chercheur est

également auteur de romans de science-fiction, de

jeux de rôle et de projets cinématographiques.

En parallèle, il s’implique dans un projet de chaire intitulée

« science et jeu vidéo » entre l’École polytechnique

et Ubisoft. Cette chaire, signée en 2019, vise à

introduire de plus en plus les sciences dans les jeux

vidéo et à former des professionnels en proposant

de nouveaux cours à Polytechnique.

« Il pourra s’agir

d’un cours de game design ou de storytelling dans

le cadre de l’enseignement en sciences humaines,

ou d’un cours orienté vers les moteurs de jeu en lien

avec l’informatique graphique et l’animation 3D »,

explique le directeur de recherche.

Autre objectif de

la chaire : réfléchir aux méthodes d’éducation par le

jeu et réunir scientifiques et industriels lors d’un colloque

dédié aux sciences et aux jeux vidéo.

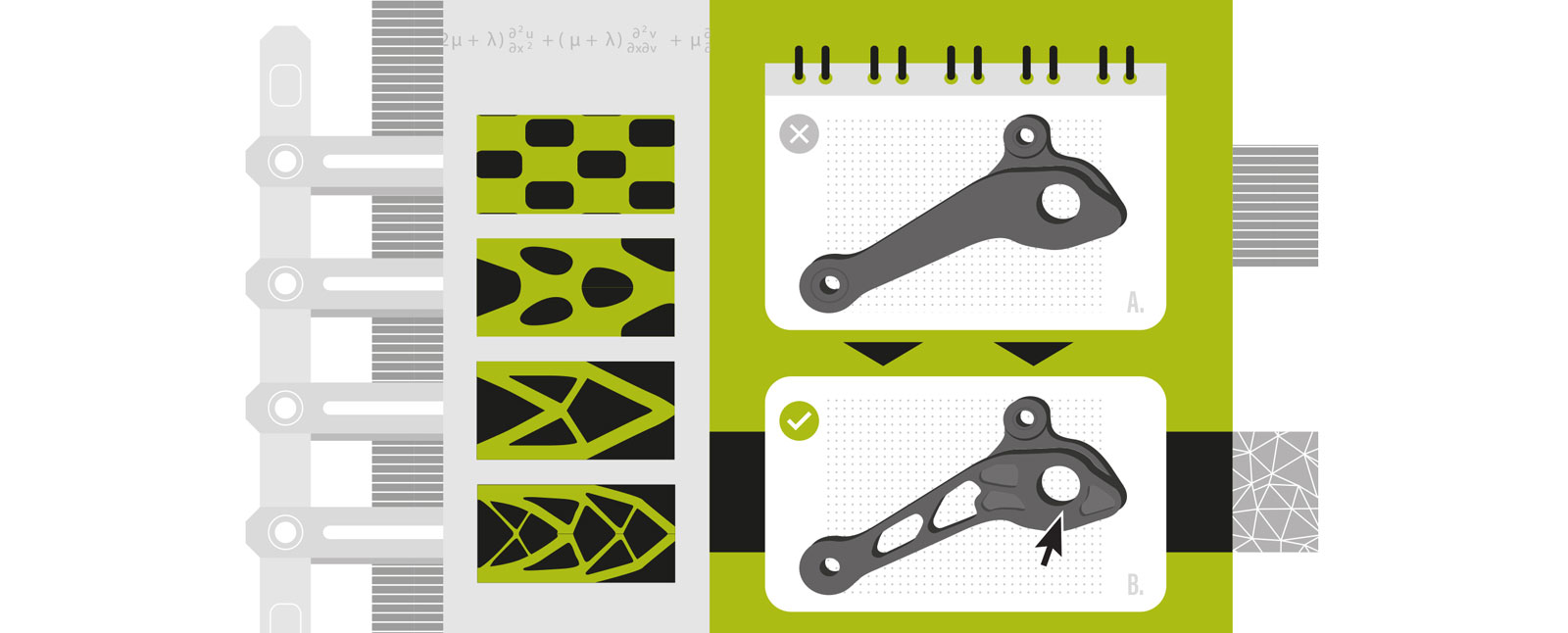

- #FabricationAdditive -

Avec le succès de l’impression 3D, les algorithmes

d’optimisation de forme développés

par le Centre de mathématiques appliquées

de l’École polytechnique connaissent un

nouvel essor.

Utilisés pour optimiser le design des pièces

industrielles, ils existent depuis une vingtaine d’années

mais leur domaine d’application était, jusqu’à récemment,

limité par les processus classiques de fabrication.

« Afin de respecter les contraintes, liées par exemple au

démoulage, nous étions obligés de limiter l’inventivité

des algorithmes », explique le mathématicien Grégoire

Allaire, spécialiste de l’optimisation des structures. Grâce

à l’arrivée de la fabrication additive, en particulier métallique,

les pièces créées par ces algorithmes, trop difficiles

à construire auparavant, deviennent aujourd’hui

concevables.

Mais cette nouvelle liberté s’accompagne aussi de

contraintes. « Le procédé, qui consiste à faire fondre

à très haute température des couches successives de

poudre de métal sous l’effet d’un laser, engendre des

contraintes liées au risque de déformation du métal lorsqu’il

refroidit », indique le mathématicien.

Pour cela, les

logiciels d’optimisation partent d’une forme initiale et

calculent, grâce à un processus itératif, une meilleure

solution que la précédente.

Ils minimisent ainsi les déformations

subies et améliorent les critères tels que le poids

de la structure, sa solidité et la résistance des matériaux,

jusqu’à obtenir la meilleure forme possible.

Ces procédés de fabrication additive métallique

ouvrent la voie à de nouvelles applications originales,

mais certaines entraves subsistent, comme le coût.

Pour

y remédier, l’École participe au projet Sofia, qui implique

des industriels et des établissements académiques, afin

de fournir des outils de recherche pour perfectionner la

filière française de fabrication additive métallique et la

faire rayonner dans le monde entier.

- #SpacialisationSonore -

Des chercheurs en mathématiques appliquées ont mis au point un système

de guidage audio à destination des malvoyants.

Ces derniers, grâce à ce

logiciel de spatialisation 3D sonore et à l’aide d’un simple casque audio,

peuvent suivre la trajectoire d’un objet sonore dans l’espace. L’objectif : leur

permettre de pratiquer des activités sportives en quasi-autonomie.

Pour développer ce logiciel, les chercheurs ont utilisé des calculs mathématiques

complexes, afin de modéliser précisément les fonctions utiles à la construction d'un

espace sonore réaliste.

En calculant numériquement la propagation des ondes

acoustiques dans un environnement défini, comme un auditorium, un monument historique

ou le creux du pavillon de l’oreille, les mathématiciens s’attellent à reproduire

les caractéristiques des ondes en chaque point

de l’espace.

Une fois couplé à un dispositif de localisation installé

au niveau de la tête et du corps, le logiciel guide

les personnes malvoyantes en toute sécurité. Lors

d’expériences, réalisées en partenariat avec l'association

MixHandi Cap sur la vie, Stéphane le Sueur,

athlète non-voyant, a ainsi pu courir et pratiquer le

roller en suivant un guide sonore virtuel qui le devançait.

Ces recherches pourraient permettre aux

déficients visuels de pratiquer des activités sportives

avec plus d'autonomie et de répondre ainsi à un

enjeu sociétal important.

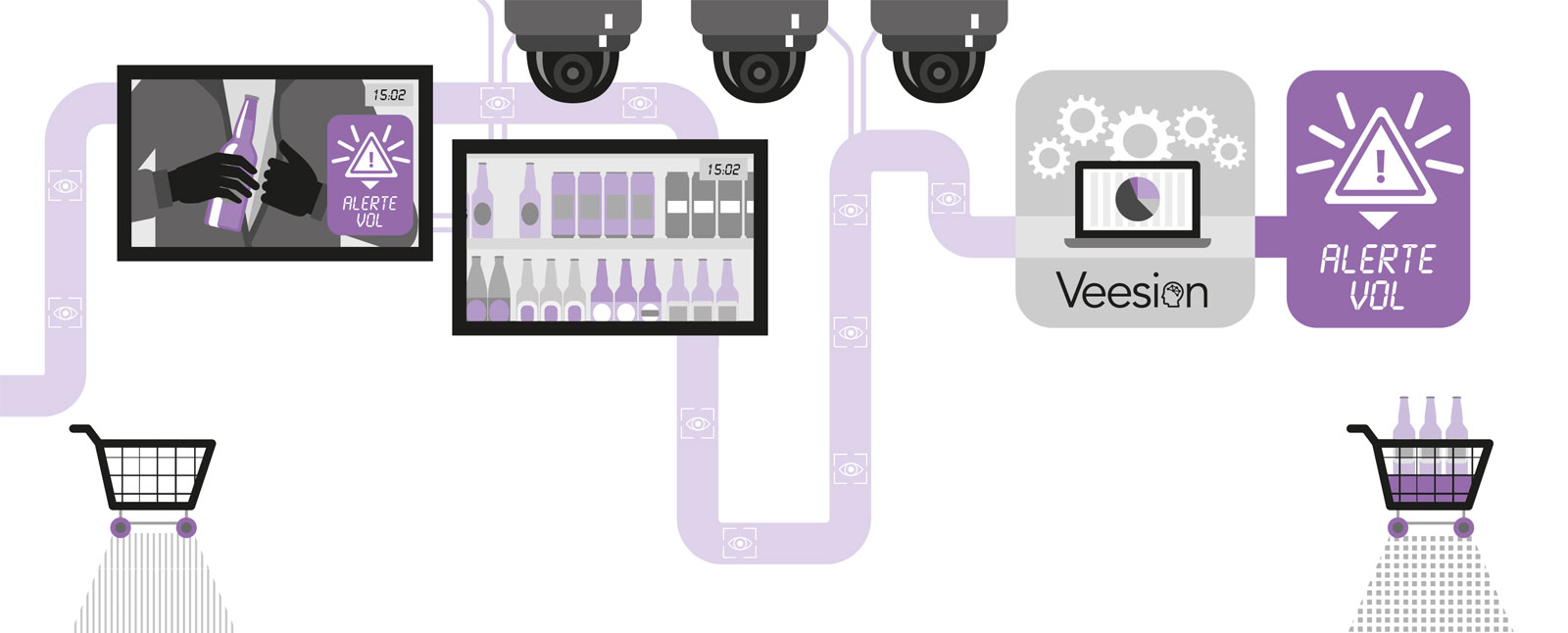

- #IntelligenceArtificielle -

Dans la grande distribution, le coût des pertes

liées aux vols est estimé entre 1 à 2 % du chiffre

d'affaires, soit 120 milliards de dollars chaque

année.

Pour lutter contre ce fléau, trois étudiants

du master Data science for business, un double diplôme

de l'X avec HEC, ont créé leur start-up pour détecter

automatiquement et en temps réel les vols dans les

grandes surfaces.

Les étudiants ont développé un logiciel

d'intelligence artificielle basé sur la reconnaissance

des gestes par la vidéo.

« Notre technologie repose sur

un algorithme de deep learning, une technique qui utilise

les réseaux de neurones pour analyser la séquentialité

des images », explique Thibault David, co-fondateur

de la start-up Veesion. Leur intelligence artificielle est

capable de relier les images entre elles pour identifier

l'enchaînement des mouvements.

À l'heure actuelle, les systèmes de vidéosurveillance,

dont le coût représente jusqu'à plusieurs millions d'euros

pour une centaine de caméras par magasin, ne sont pas

des investissements rentables comparés au faible taux

de vols évités.

« Un opérateur peut traiter en simultané

les images de six caméras maximum, alors qu'on lui demande

de les analyser pour une centaine d'appareils »,

précise Thibault David.

L'équipe propose une complémentarité

homme-machine avec un filtre d'intelligence

artificielle capable d'analyser en continu les 100 écrans

et de remonter à l'opérateur uniquement les séquences

pour lesquelles il existe une forte probabilité de vol. Leur

technologie sera déployée en France et à l'international

en 2019.

L'équipe compte poursuivre ses travaux de recherche

sur la détection de mouvements en vidéo en

recrutant des doctorants pour améliorer son logiciel.

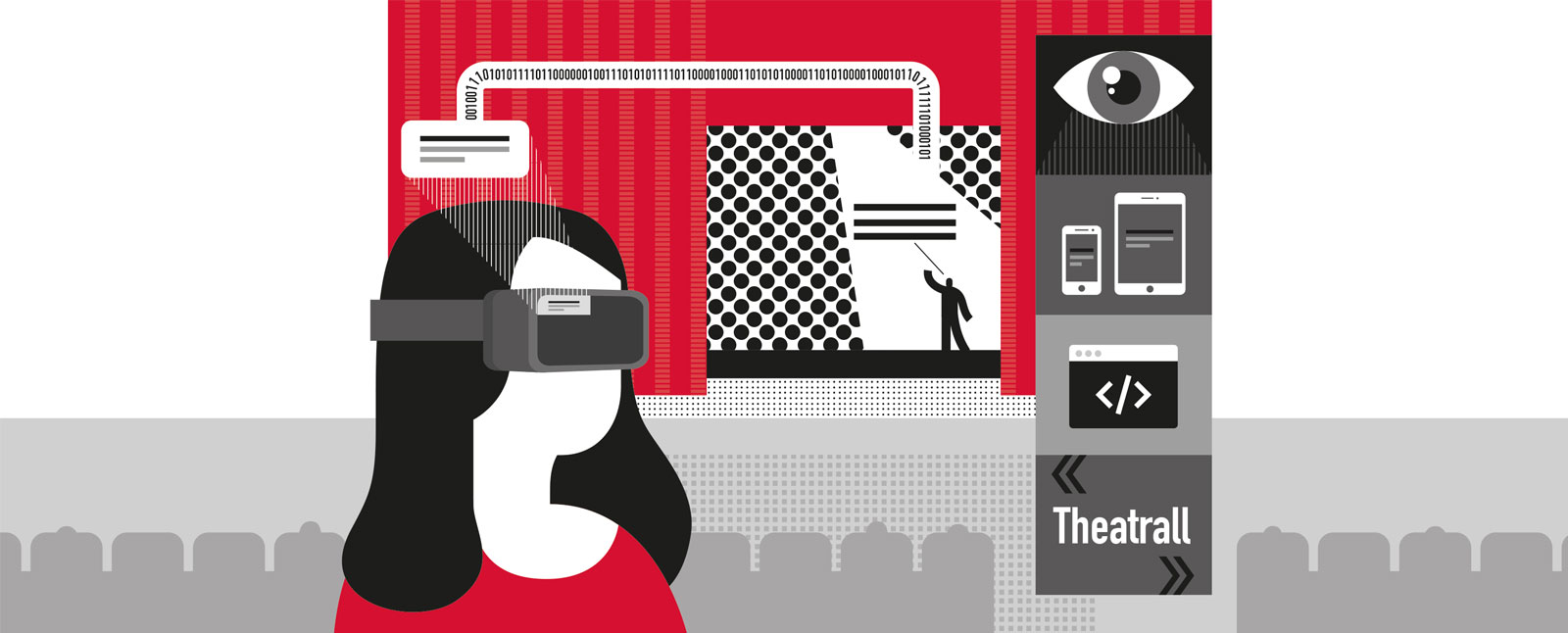

- #RéalitéAugmentée -

Cinq élèves du cycle ingénieur ont lancé la

start-up Theatrall qui propose une solution

de surtitrage individualisé, automatique et

en temps réel des pièces de théâtre.

Cette innovation, née d’un projet scientifique collectif

de deuxième année et lauréate de la finale française de

la Microsoft Imagine Cup 2018, repose sur la reconnaissance

vocale.

« Notre algorithme est capable d’écouter

les acteurs, de comprendre le sens global de leur réplique

et de la retrouver dans le texte de la pièce pour la

transmettre au spectateur dans la langue de son choix »,

indique Daniel Huynh, l’un des fondateurs de la start-up.

Grâce à ce système basé sur l’intelligence artificielle, les

sourds et malentendants peuvent suivre une pièce de

théâtre de façon optimale.

La solution est accessible

grâce à une application web disponible sur smartphone

et l’équipe prévoit également un prêt de lunettes

connectées, ou de tablettes, pour l’affichage des

surtitres.

Cette innovation, déjà utilisée dans le cadre

d’un partenariat avec la Comédie française, pourrait

intéresser de nombreuses autres institutions. Le système

suscite déjà l’intérêt d’une marque de luxe et les élèves

imaginent des applications à l’international.

« Le marché de la comédie musicale est très développé

en Angleterre et l’appétence pour le théâtre est aussi

très répandu en Allemagne et en Italie », indique Daniel

Huynh qui envisage aussi de fournir le système aux

cinémas pour toucher le public étranger.

- #Blockchain -

Avant même que le concept n’existe, Thierry

Rayna, chercheur en sciences de gestion,

travaillait déjà, il y a 15 ans, sur la blockchain.

Aujourd’hui, il effectue des recherches sur l’impact

des technologies numériques sur les business models.

Après avoir étudié le cloud, l’impression 3D et l’internet des

objets, le chercheur s’est penché sur les cas d’usages et

sur l’intérêt de la blockchain pour les entreprises.

Aujourd’hui, les consommateurs deviennent également

des producteurs : ils produisent du contenu numérique

en créant des vidéos, du service en louant leur appartement,

et demain ils fabriqueront des objets grâce à

l’impression 3D.

Or, s’ils étaient auparavant tributaires de

l’existence d’intermédiaires de confiance, la blockchain

permet aujourd’hui de s’en affranchir.

Ainsi, en faisant

émerger de nouveaux marchés de manière très rapide,

cette technologie crée des ruptures et bouleverse les activités.

« Pour les start-up, elle représente d’énormes opportunités

et leur permet de concurrencer les acteurs établis

du marché, pas nécessairement frontalement mais en les

contournant.

Pour ces derniers, elle implique de se transformer

et d’adapter leurs compétences et leurs services à

ces nouveaux usages », indique le chercheur.

Dans cette optique, il a mis au point un outil de diagnostic

des technologies et de leur impact sur les business

models existants.

Son idée : comprendre à la fois la technologie

et le marché, tout en établissant un lien entre

les deux, afin d’anticiper les ruptures probables pouvant

survenir à l’arrivée d’une technologie.

Car parfois, il n’y a

même pas besoin d’utiliser une technologie pour que la

rupture s’opère. Une menace seule peut suffire.

- #Modélisation 3D -

Léonard de Vinci, Clément Ader ou les frères Montgolfier ont en commun d’avoir

imaginé des machines volantes.

Depuis deux ans, des élèves de deuxième année

de l’École polytechnique se prêtent, eux aussi, à l’exercice. Dans le cadre

d’un Module appliqué en laboratoire -Modal-, ils inventent leur machine, la

modélisent par ordinateur et fabriquent leur prototype en 3D.

« Ce module s’appuie sur

les avancées en informatique graphique pour matérialiser une forme imaginaire. Il fait

référence à l’univers des jeux vidéo et des effets spéciaux tout en traitant une problématique

essentielle à l’ingénieur : représenter et animer un modèle mental », indique

Marie-Paule Cani, professeure au Laboratoire d’informatique de l’X et responsable du

module « Modélisation expressive pour la fabrication 3D ».

C’est ainsi qu’ont pris vie, cette année, des vaisseaux inspirés des films de Hayao

Miyazaki, de Star Wars ou de la nature.

Pour cela, les étudiants ont dessiné leur

concept et l’ont « sculpté » virtuellement en 3D grâce à un logiciel, programmé par

leurs soins et faisant appel à une forme d’intelligence artificielle : l’aide à la création.

Le principe : coder les connaissances nécessaires pour

créer en temps réel un modèle 3D à partir d’un simple

croquis, le déformer et lui ajouter des détails par le geste.

Cette méthodologie est utilisée par Marie-Paule Cani et son

équipe du laboratoire d'informatique dans leurs recherches.

Par exemple, leur projet de « sculpture » de montagnes,

accessible au musée de l'École polytechnique, combine

des contraintes géologiques, liées au comportement des

plaques tectoniques ou de l’érosion, pour animer en temps

réel la création et l’évolution d’une chaîne montagneuse,

sous les doigts de l’utilisateur.

À travers leur Modal, les étudiants ont ainsi l’occasion

d’appréhender au plus près la recherche menée dans le

domaine de la modélisation expressive.

- #E-santé -

Près de 640 millions d'adultes seront atteints du

diabète dans le monde d'ici 2040.

La start-up

Healsy, passée par l’accélérateur de l’École

polytechnique, a développé la première plateforme

mobile pour aider les personnes diabétiques à

prendre seules des décisions sur leur traitement.

Car, malgré la mesure de glycémie, « il y a beaucoup

trop de facteurs à prendre en compte comme les repas,

l’activité physique, l’insuline déjà injectée ou encore le

stress, pour déterminer seul la bonne dose d’insuline à

s’injecter, précise Nicolas Caleca (X2004), co-fondateur

d’Healsy. Les personnes diabétiques font donc des erreurs,

avec des complications à court ou à moyen terme

potentiellement dramatiques ».

L’objectif d’Healsy est de fournir aux patients l’information

qui leur manque : la prédiction de l’évolution de leur taux

de glycémie.

Pour réaliser cette prédiction, les patients

connectent leur smartphone à leurs outils - capteurs de

glycémie et pompe à insuline - et à un traqueur d’activité.

« Toutes ces données alimentent l’application et

permettent de simuler l’évolution de la glycémie grâce

au modèle mathématique couplé à de l’intelligence artificielle

que nous développons », indique Nicolas Caleca.

Une première version de leur application sera disponible

sur le marché en 2019.

Pour aider la start-up à développer

sa technologie, des élèves de l’École polytechnique

ont conçu, dans le cadre de leur projet scientifique de

deuxième année, un brassard de traitement et de transmission

de données en continu permettant aux patients

de disposer de leur glycémie en temps réel sur leur

smartphone et à Healsy de constituer une base de données

avec les informations collectées.

Pour qui en doutait encore, l’année 2018 a une nouvelle fois montré que

la menace numérique n’est pas éthérée, et que les défis pour la sécurité

et la stabilité du cyberespace restent immenses.

Plus sophistiquées,

mieux élaborées, plus destructrices et touchant désormais toute la

société, du citoyen à la grande entreprise jusqu’à nos institutions

démocratiques, les attaques informatiques sont entrées dans une

dimension nouvelle.

Tous connectés, tous concernés, tous responsables : voilà l’approche

fondamentale que nous nous efforçons de porter. La sécurité doit sortir

de son domaine réservé pour associer l’ensemble des architectes

de la société numérique.

Car, au-delà des menaces sur la société,

l’économie, la souveraineté et la stabilité du cyberespace, il en va du

développement même des technologies. En effet, les formidables

usages rendus possibles par le numérique ne pourront être durables que

s’ils recueillent la confiance des utilisateurs.

La cybersécurité : plus qu'un coût

Celle-ci ne peut plus être appréhendée uniquement comme un poste

de coût ou un « patch » appliqué en bout de course de l’innovation. Interrogez

les experts de l’ANSSI : la cybersécurité constitue en elle‑même

un champ d’innovation passionnant, d’une grande richesse scientifique,

profondément transdisciplinaire et associant une grande variété

d’acteurs, privés et publics, en France comme à l’international. Elle pose

des défis intellectuels majeurs pour les innovateurs de tous bords.

Un défi qui dépasse l'ingénieur

Le véhicule autonome et connecté, qui a connu des progrès majeurs

ces dernières années, offre une bonne illustration de cette imbrication

des usages et des impératifs de sécurité.

La présence de voitures sans

conducteurs sur nos routes reste en effet largement conditionnée à

d’impérieuses questions de confiance et d’acceptabilité sociale.

Or beaucoup reste à faire : le système de reconnaissance de ces

véhicules peut encore être facilement berné par une altération

légère des panneaux de signalisation, les conduisant à confondre les

panneaux « stop » et « route prioritaire ».

Si ces défis concernent naturellement les ingénieurs, les artisans

des politiques publiques, du droit et des relations internationales ne

sont pas en reste.

Comment oeuvrer à la stabilité du cyberespace ?

Doit-on permettre aux acteurs privés de se faire justice eux-mêmes, de

riposter aux attaques dans un contexte où les entreprises deviennent

elles-mêmes des « champs de bataille » ? La stabilité du cyberespace

est un sujet qui bouscule les habitudes politiques, diplomatiques et

militaires.

Les questions sont nombreuses et les perspectives excitantes,

passionnantes, structurantes.

Ingénieurs, juristes, designers, experts en politiques publiques, en relations

internationales, ergonomes, start-up, grands groupes, citoyens…

la sécurité du numérique est définitivement l’affaire de tous.

Écrans tactiles, capteurs, composants électroniques, les innovations

technologiques permises par les progrès spectaculaires en sciences des

matériaux sont omniprésentes autour de nous.

La ‘wish-list’ pour le futur

est longue et variée : nous cherchons un matériau non-toxique, chimiquement

stable et peu onéreux, susceptible de servir d’aimant permanent

dans les moteurs de voitures électriques ou dans les éoliennes ; nous

rêvons de trouver des matériaux pour fabriquer une batterie à même de

stocker la production énergétique d’une ferme photovoltaïque…

Mais comment procéder ? Faut-il tester toute nouvelle composition

chimique, au risque de nous perdre en chemin ? L’idéal serait de disposer

de méthodes pour prédire les propriétés des matériaux par des considérations

théoriques, complémentées par des calculs numériques.

Le numérique au service de la science des matériaux

C'est là qu'interviennent les théoriciens de la matière condensée du

Centre de physique théorique. Le développement d'approches numériques

pour calculer les propriétés des matériaux "ab initio", c'est-à-dire

sans paramètres ajustables, est au coeur du projet « Predictive electronic

structure calculations for materials with strong electronic correlations

: Long-range Coulomb interactions and quantum dynamical screening

» que nous portons, financé par le European Research Council.

La tâche n'est pas triviale.

Les propriétés des matériaux sont le résultat

d'une conspiration subtile de leurs constituants, noyaux et électrons.

Comprendre leurs propriétés magnétiques, optiques ou de conduction

revient à résoudre les équations de la mécanique quantique qui

gouvernent le comportement des électrons à l'échelle microscopique.

Or, loin d'être individualistes, les électrons interagissent en général fortement

les uns avec les autres. Nous avons donc affaire à ce que les

physiciens appellent un immense "problème à N corps quantiques".

Pour ne rien arranger, les composés les plus intéressants sont ceux qui

sont le plus en proie à ces effets collectifs complexes. Ces matériaux

sont dits "corrélés", car le comportement d'un électron est dépendant

de celui de tous les autres.

Plus spécifiquement, les théoriciens du Centre de physique théorique se

sont récemment intéressés au caractère retardé de la répulsion électrostatique

entre les électrons. En effet, lorsqu'on ajoute une charge

dans un solide, les électrons se réorganisent afin d'obtenir une position

plus stable.

Cette réorganisation réduit la répulsion entre deux charges,

mais n'est pas instantanée. Ainsi, si un électron se déplace au sein du

solide, il sera suivi par une sorte de nuage de charge permettant de

réduire sa charge effective mais deviendra plus "lourd". Si l'on veut prédire

et comprendre précisément les propriétés des matériaux corrélés,

il paraît nécessaire de prendre en compte cet "écrantage dynamique"

grâce à des méthodes développées très récemment au Centre de physique

théorique.

Ses théoriciens ont réalisé des simulations numériques

sur une grappe d'ordinateurs dédiés, et, Ô joie ! leurs résultats sont en

accord avec les données expérimentales !

Ce résultat constitue une étape très prometteuse sur le chemin du

calcul ab initio.

À l'horizon se dessine la perspective de pouvoir un jour

faire de l'alchimie sur ordinateur, même dans le cas le plus difficile, celui

des matériaux corrélés.

Les données numériques sont devenues omniprésentes dans les domaines

scientifiques, industriels et personnels. Elles sont massives et de

tous types : textes, images, sons, vidéos, historiques de navigation internet,

capteurs divers...

Un développement facteur de nouveaux enjeux

Ces données requièrent des traitements automatisés de plus en plus

complexes, qui vont au-delà de leurs indexations ou de calculs de

statistiques simples, afin par exemple de reconnaître des objets dans

une image, traduire un texte d’une langue à une autre, ou prédire quel

produit proposer à ses clients. Pour toutes ces tâches dites d’intelligence

artificielle, qui semblaient trop difficiles pour une machine il y a

quelques années, les performances actuelles permettent une utilisation

par le plus grand nombre.

Ces progrès récents sont dus à une capacité

de calcul fortement accrue, à un volume de données important, ainsi

qu’au développement de nouvelles architectures algorithmiques d’apprentissage

automatique pour en tirer parti.

Au-delà de l’engouement médiatique, le développement de l’intelligence

artificielle s’accompagne de nombreuses questions et de nouveaux

enjeux scientifiques : quelles sont ses limites, quelles seront les interactions

avec les autres disciplines scientifiques ? ; industriels : quelles

seront les applications futures ? ; et sociétaux : quel sera l’impact sur

l’emploi et la vie des citoyens ?

Les atouts français

Pour faire face à ces défis, la France a toute sa place, si elle sait saisir

sa chance. Au niveau scientifique, la formation des ingénieurs français

est mondialement reconnue et les chercheurs sont présents au meilleur

niveau dans les différentes communautés scientifiques liées à l’intelligence

artificielle.

Cependant, la fuite des cerveaux vers l’industrie et

le monde académique étrangers, dont une des raisons principales est

le salaire non compétitif proposé aux jeunes chercheurs, constitue une

menace sérieuse pour le maintien de cette excellence.

Au niveau industriel, il y a peu de grandes sociétés françaises technologiques

de type « GAFAM* », mais beaucoup de start-up et de grands

champions industriels mondiaux dans tous les secteurs d’activité.

Récolter

les fruits de l’intelligence artificielle et ainsi éviter l’absorption par

ces géants technologiques ne pourra se faire qu’en engageant une

réflexion stratégique sur l’importance des données dans l’entreprise, et

pas simplement une vision technique de solutions logicielles ou d’achat

de matériel.

En particulier, étant donnée la rapidité des transferts technologiques

entre laboratoires académiques et industrie, il faudra un

recrutement massif d’experts en intelligence artificielle, pour lesquels

un doctorat et une rémunération compétitive sont indispensables. Les

« GAFAM » l’ont déjà bien compris.

L’économie collaborative a bâti une infrastructure de la confiance, dont

le socle est la data : l’utilisateur d’un service collaboratif, en communiquant

des informations personnelles –nom, âge, adresse, photo, etc.–,

entre avec un inconnu dans une relation de transparence qui crée la

confiance.

Plus il fournira de données, plus la confiance sera grande et

plus il effectuera de transactions. C’est la clé d’accès à une multitude

de services : covoiturage, prêt de matériel, financement, échange de

maisons ou de compétences.

La confiance au sein des systèmes collaboratifs

est d’ailleurs remarquablement forte : selon une étude menée

par BlaBlaCar auprès de ses membres, le taux de confiance entre utilisateurs

du service est similaire à celui qui existe entre membres d’une

même famille, et supérieur à celui entre collègues. C’est dire le pouvoir

de la data !

Celle-ci enclenche ensuite un deuxième comportement vertueux : l’utilisateur

de services collaboratifs, désormais habitué à faire confiance,

étendra progressivement l’échange et le partage à d’autres usages. Il

est plus facile de mettre sa maison à la disposition d’un inconnu quand

on a déjà expérimenté l’économie du partage à travers du covoiturage,

par exemple.

Le digital, vecteur de lien social

Voilà qui contredit l’idée, pourtant répandue, selon laquelle le digital

détruit le lien social : dans l’économie collaborative, il retisse au

contraire entre les individus le lien que le développement technologique

avait affaibli.

Pourquoi ? Parce qu’il réintègre des interactions humaines

dans nos activités de tous les jours, en conditionnant le service à

la rencontre. Il redéfinit ainsi la façon dont nous sommes connectés les

uns aux autres et reproduit, dans des communautés élargies, le cercle

de confiance que l’on partageait auparavant à l’échelle d’un village

ou d’une association.

Les enjeux de la data

Mais pour exister, la confiance a besoin d’un cadre. Les nombreux

scandales sur la sécurisation et l’exploitation de la data qui frappent les

acteurs majeurs du digital créent une défiance croissante chez les utilisateurs.

À l’heure où la data devient la matière première des entreprises,

cela pose deux enjeux majeurs. D’une part, l’entreprise qui récolte les

données doit être transparente sur la sécurisation et l’exploitation de

la data. D’autre part, l’utilisateur doit avoir une compréhension claire

et immédiate de la plus-value que lui apporte la transmission de ses

données.

Ces deux conditions sont impératives pour permettre à l’entreprise de

lier data et confiance. Sans elles, l’accès aux données personnelles

menace de se tarir, car les utilisateurs, de plus en plus avertis et récalcitrants,

en font désormais un enjeu de liberté individuelle.

Reste toutefois une question fondamentale : celle de l’outil. Car tant

que nous ne disposerons pas de grandes plateformes européennes

pour écrire nos propres règles de gestion des données, nous ne serons

pas maîtres du jeu... au détriment des individus et de nos entreprises.

Le temps de la lecture de cette contribution, 20 000 objets auront été

connectés à internet autour du monde, 30 millions en une journée. C’est

une transformation massive.

L’internet des objets a commencé à faire le buzz il y a plus d’une dizaine

d’années, sous le concept du « machine to machine ». Après l’internet

des personnes, cette deuxième vague s’accélère aujourd’hui, avec

plus de 50 milliards d’objets connectés avant la fin 2020, soit dix fois plus

que de personnes !

Le champ d’application que permet l’internet des objets est immense.

Dans les bâtiments par exemple, des centaines d’objets et capteurs sont

désormais connectés : les technologies numériques permettent de visualiser,

de corréler, de piloter.

Le pilotage dynamique et intelligent du

bâtiment change complètement la donne énergétique et remet l’utilisateur

au coeur de l’action. En parallèle, le développement de nouvelles

applications digitales autour de la maquette numérique permet

de coordonner tous les corps de métier, du design à la maintenance, et

révolutionne toute cette industrie.

Des transformations qui dépassent l'imagination

La transformation digitale des objets aura des implications structurantes

sur le monde de demain, qu’elles soient économiques ou sociétales,

dont certaines ne sont même pas envisageables aujourd’hui. Il nous

faudrait imaginer le croisement de chaque type d’application existante

ou à développer par micro-segment de marché pour commencer à entrapercevoir

l’immensité de cette révolution systémique...

Sans en oublier

les enjeux pour la sécurité des personnes et des biens qui lui sont reliés.

Prenons l’exemple de la 4e révolution industrielle : après l’automatisation

de la production, c’est dorénavant l’exploitation qui est bouleversée

grâce à l’analyse de données récoltées sur les machines ainsi que la

traçabilité des produits et des matières à travers différentes chaînes de

production.

Le monde industriel de demain – ou devrais-je dire d’aujourd’hui

– embarque l’intelligence artificielle et va accélérer la révolution

des chaînes d’approvisionnement, la personnalisation de la production,

l’amélioration de la sécurité des personnes.

Les machines sur

les chaînes de production sont désormais connectées, sensibles à leur

environnement, capables de s’adapter, flexibles et communicantes,

ouvrant la voie à une industrie respectueuse de l’environnement et

de l’homme.

Une opportunité à saisir, un nouveau regard sur le monde

L'internet des objets est certes une somme de technologies, mais elle

nous donne aussi des possibilités que nous n’imaginions pas, et de nouvelles

responsabilités.

Elle change notre économie et notre manière de

percevoir le monde. Notre manière de travailler évoluera vers plus de

transversalité, plus de collaboration, avec des plateformes, des start-up,

des acteurs de tous horizons.

Elle change notre manière de prendre des

décisions et notre mode de management, plus à l’écoute, plus flexible.

Et c’est bien l’Homme derrière la technologie qui doit se saisir de l’opportunité

de l’internet des objets pour accélérer les révolutions qu’elle

permet, qu’il s’agisse par exemple de la transition énergétique ou plus

simplement de créer les modes de travail de demain.